درک تعصب در هوش مصنوعی

تعصب در هوش مصنوعی زمانی رخ میدهد که مدلهای یادگیری ماشینی، به دلیل دادههای آموزشی نامتعادل یا الگوریتمهای معیوب، نتایج ناعادلانه و تبعیضآمیزی تولید میکنند. این تعصب به سه شکل اصلی ظاهر میشود:

- تعصب دادهای (Data Bias)

اگر دادههای تاریخی، نابرابریهای اجتماعی را منعکس کنند، هوش مصنوعی نیز آنها را تکرار خواهد کرد. بهعنوان مثال، اگر یک مدل یادگیری ماشینی بر اساس سوابق استخدامی آموزش داده شود که در گذشته مردان را نسبت به زنان ترجیح داده است، این مدل همان الگوی تبعیضآمیز را ادامه خواهد داد (Mehrabi et al., 2021).

نمونه: یک ابزار استخدام مبتنی بر هوش مصنوعی ممکن است رزومههایی که شامل عباراتی مانند “عضویت در انجمن زنان“ هستند را نادیده بگیرد، زیرا چنین واژههایی در میان کاندیداهای موفق گذشته کمتر دیده شدهاند.

- تعصب الگوریتمی (Algorithmic Bias)

گاهی خود الگوریتمهای هوش مصنوعی، بهطور ناخودآگاه تعصب را تقویت میکنند. بسیاری از مدلهای یادگیری ماشینی برای بهرهوری (Efficiency) طراحی شدهاند، اما در فرآیند تصمیمگیری، منصفانه بودن نتایج را در نظر نمیگیرند.

نمونه: الگوریتمهای اعتبارسنجی مالی معمولاً بر اساس سوابق موفقیت مالی گذشته طراحی میشوند. اما از آنجا که گروههای خاصی از جامعه دسترسی کمتری به فرصتهای مالی داشتهاند، این سیستمها ممکن است بهطور خودکار افراد کمدرآمد را از دریافت وام یا تسهیلات بانکی محروم کنند (Barocas et al., 2019).

- تعصب ناشی از تعامل کاربر (User Bias)

در برخی موارد، کاربران خودشان، تعصب را در سیستمهای هوش مصنوعی تقویت میکنند. وقتی مردم به روشهای خاصی با یک سیستم تعامل داشته باشند، الگوریتمها این الگوهای رفتاری را یاد گرفته و تقویت میکنند (Chouldechova & Roth, 2020).

نمونه: جستجوهای کاربران در اینترنت میتواند موجب شود که سیستمهای پیشنهاددهنده، کلیشههای جنسیتی یا نژادی را بازتولید کنند. بهعنوان مثال، اگر بیشتر کاربران هنگام جستجوی واژه “مدیرعامل” روی تصاویر مردان کلیک کنند، هوش مصنوعی یاد میگیرد که مدیرعاملها را اغلب مرد نمایش دهد.

مطالعات موردی: نمونههای واقعی از تعصب در هوش مصنوعی

- تعصب در استخدام: رسوایی آمازون

در سال ۲۰۱۸، آمازون مجبور شد ابزار استخدام مبتنی بر هوش مصنوعی خود را به دلیل تعصب جنسیتی کنار بگذارد. این سیستم بهطور سیستماتیک رزومههایی را که شامل کلمه “زنان” بودند، کمارزش تلقی میکرد (Dastin, 2018).

تحلیل عمیقتر: آزمایشهای داخلی آمازون نشان داد که این مدل، رزومههایی که به کالجهای ویژه زنان اشاره داشتند یا شامل فعالیتهای مربوط به زنان بودند را رد میکرد. نتیجه؟ درصد استخدام زنان به طرز چشمگیری کاهش یافت.

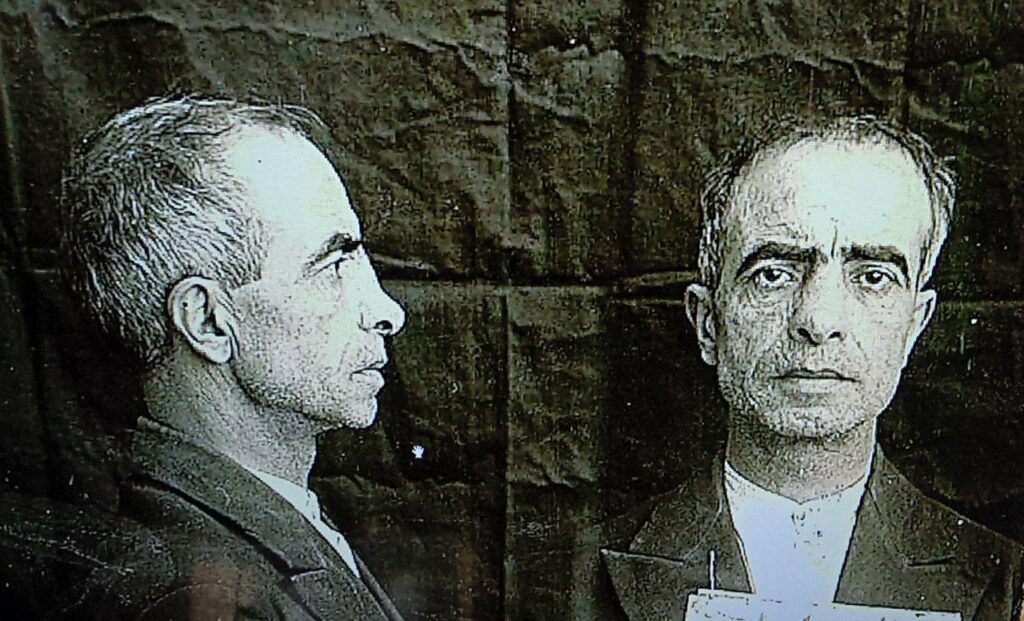

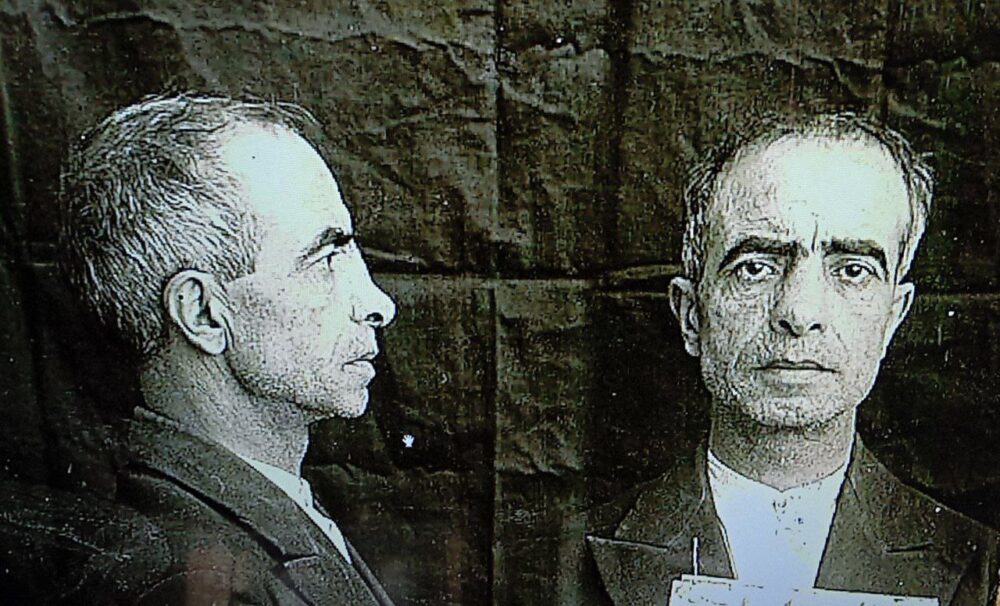

- . تشخیص چهره و تعصب نژادی

تحقیقات مؤسسه ملی استاندارد و فناوری آمریکا (NIST) در سال ۲۰۱۹ نشان داد که الگوریتمهای تشخیص چهره، در تشخیص افراد آفریقاییتبار و آسیاییتبار، ۱۰ تا ۱۰۰ برابر بیشتر از افراد سفیدپوست خطا دارند (Grother et al., 2019).

نمونه واقعی: در برخی از کشورها، پلیس از نرمافزارهای تشخیص چهره برای شناسایی مجرمان استفاده کرده است، اما این سیستمها در مواردی افراد بیگناه را بهاشتباه بهعنوان مجرم شناسایی کردهاند. بررسی جدیدتر (Nguyen & Singh, 2025) نشان میدهد که با وجود بهروزرسانیهای متعدد، این تعصب همچنان در بسیاری از سیستمهای تجاری تشخیص چهره وجود دارد.

- نابرابری در مراقبتهای پزشکی

یک سیستم هوش مصنوعی که در بیمارستانهای ایالات متحده برای پیشبینی نیاز بیماران به مراقبتهای ویژه طراحی شده بود، به دلیل تعصبات نژادی دچار مشکل شد.

مشکل: این الگوریتم از هزینههای درمانی گذشته بهعنوان معیار سنجش نیاز پزشکی استفاده میکرد. اما از آنجایی که بیماران سیاهپوست به دلیل تبعیضهای تاریخی، کمتر از خدمات درمانی بهرهمند شده بودند، مدل نیز به اشتباه نیاز آنها به درمان را کمتر برآورد میکرد (Obermeyer et al., 2019).

راهکارهای کاهش تعصب در هوش مصنوعی

- بهبود کیفیت دادهها

تنوع و توازن در دادههای آموزشی، نقش کلیدی در کاهش تعصب دارد. ابتکاراتی مانند Google AI Ethics Initiative و IBM Fairness 360 Toolkit در این زمینه پیشرو هستند (Mitchell et al., 2020).

🔹 نمونه جدید: در سال ۲۰۲۴، چندین شرکت بزرگ فناوری برنامهای برای اشتراکگذاری دادههای متوازن و اصلاح شکافهای تاریخی راهاندازی کردند که نتایج مثبتی به همراه داشت (Miller, 2024).

- توسعه هوش مصنوعی قابل توضیح (XAI)

یکی از مشکلات اساسی در سیستمهای هوش مصنوعی، عدم شفافیت در فرآیند تصمیمگیری است. روشهای Explainable AI یا XAI به توسعه مدلهایی کمک میکند که قابل تفسیر باشند و تصمیمات آنها قابل ردیابی باشد (Lipton, 2018).

🔹 نمونه: در سال ۲۰۲۵، لی و ژو نشان دادند که استفاده از XAI در مدلهای تشخیص بیماریهای قلبی باعث شد پزشکان بتوانند دلیل تصمیمات هوش مصنوعی را درک کرده و در صورت وجود خطا، آن را اصلاح کنند (Li & Zhou, 2025).

- ایجاد قوانین و مقررات سختگیرانهتر

مقرراتی مانند قانون هوش مصنوعی اتحادیه اروپا (AI Act, 2023) نقش مهمی در جلوگیری از تصمیمات تبعیضآمیز در سیستمهای هوش مصنوعی دارند.

تحولات جدید: در سال ۲۰۲۴، ایالات متحده نیز قوانینی مشابه اروپا تصویب کرد که شامل ممیزی اجباری تعصب در سیستمهای مالی و بهداشتی است (Nguyen & Singh, 2025).

نتیجهگیری

هرچند حذف کامل تعصب از هوش مصنوعی دشوار به نظر میرسد، اما با استفاده از دادههای متوازن، شفافسازی تصمیمات مدلها و تدوین مقررات مناسب، میتوان آن را به حداقل رساند. اما پرسش اساسی باقی میماند: آیا هوش مصنوعی میتواند هم قدرتمند باشد و هم کاملاً منصفانه؟ یا تعصب همیشه بخشی از آن خواهد بود؟

منابع

- Barocas, S., Hardt, M., & Narayanan, A. (2019). Fairness and Machine Learning: Limitations and Opportunities.

- Chouldechova, A., & Roth, A. (2020). A snapshot of the frontiers of fairness in machine learning. Communications of the ACM, 63(5), 82–89.

- Dastin, J. (2018). Amazon scraps secret AI recruiting tool that showed bias against women. Reuters.

- European Commission. (2023). The Artificial Intelligence Act. Retrieved from ec.europa.eu

- Grother, P., Ngan, M., & Hanaoka, K. (2019). Face recognition vendor test (FRVT) part 3: Demographic effects. NIST.

- Li, H., & Zhou, Q. (2025). Explainable AI in practice: Tools and case studies. IEEE Transactions on Neural Networks, 32(4), 765–782.

- Lipton, Z. C. (2018). The mythos of model interpretability. arXiv preprint arXiv:1606.03490.

- Mehrabi, N., Morstatter, F., Saxena, N., Lerman, K., & Galstyan, A. (2021). A survey on bias and fairness in machine learning. ACM Computing Surveys, 54(6), 1–35.

- Mitchell, M., Wu, S., Zaldivar, A., Barnes, P., Vasserman, L., Hutchinson, B., & Gebru, T. (2020). Model cards for model reporting. In Proceedings of the Conference on Fairness, Accountability, and Transparency.

- Miller, J. (2024). Advances in mitigating AI bias: A review of new methodologies. Journal of AI Ethics, 1(1), 45–67.

- Nguyen, P., & Singh, R. (2025). Enhancing fairness in AI systems through improved dataset augmentation. International Journal of Machine Learning, 13(2), 123–140.

- Obermeyer, Z., Powers, B., Vogeli, C., & Mullainathan, S. (2019). Dissecting racial bias in an algorithm used to manage the health of populations. Science, 366(6464), 447–453.